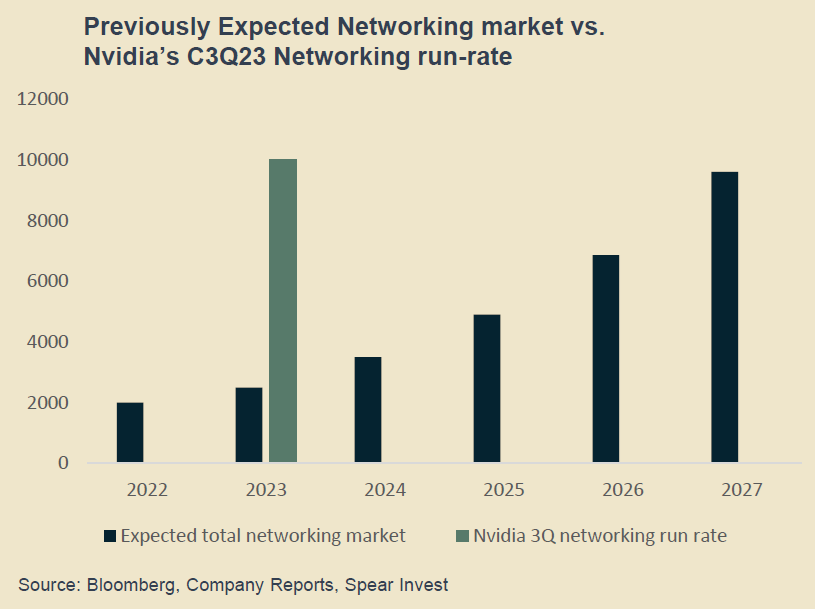

运行大模型的 AI 服务器都数据传输的网络带宽要求是传统服务器的 10-100x 倍。以 Nvidia InfiniBand 为代表的高性能网络互联的需求大增。

Spear Invest 预计 AI 数据中心网络设备的市场空间在 2027 会提升到 1,000 亿美元。

门店导购是手机等终端产品行销的重要渠道,电信运营商一般都会在门店设置手机展示台。澳洲运营商 Optus 最近在悉尼和墨尔本部署一种新型智慧导购屏,产品方案来自深圳的 <玮锡科技> 。

如附图所示,长方形的屏幕代替柜台上的传统小隔断,用来作为手机展示的背景。屏幕上的内容会根据消费者的情况做一些互动,比如:拿起某部手机,屏幕给出一些上下文内容或者价格对比等。

此类智慧屏属于一种微型创新,潜在价值:

(1) 不少消费者愿意自己看商品,不愿意频繁被导购人员打扰,觉得不自在;智慧屏可以做一些上下文提醒,算被动提醒,可能体验会比较自然;

(2) 新冠疫情估计还会放大此类沟通需求;

(3) 智慧屏通过传感器可对人流进行大数据采集和分析,便于后续的精细化运营;

(4) 智慧屏和展示台上的手机,甚至手机屏幕是可以 “互动”...

从英伟达 Nvidia 2025 财年 Q2 的收入结构看,数据中心贡献了 263 亿美元,而汽车只贡献了 3 亿美元,即便英伟达近年在加强汽车自动化的技术研发。

侧面反映了,数据中心的算力需求是汽车的 88x 倍。汽车首先是一个物理世界的 “实体大件”。汽车的智能化程度,代表了整个物理世界的实际智能化程度。

生成式 AI(Gen AI)在一些语境下被称呼为 AIGC(AI 生成内容)是有原因的。目前访问量大的生成式 AI 应用,基本都是生成某种内容。

2022 - 2023 年期间,舆论非常喜欢把生成式 AI 称为下一轮工业革命。以至于只看公众号文章,感觉一年时间就可以工业革命好几轮。

而汽车行业就是工业行业的代表。如果 Nvidia 汽车板块的收入超过数据中心的收入,也许可认为下一轮工业革命到了。

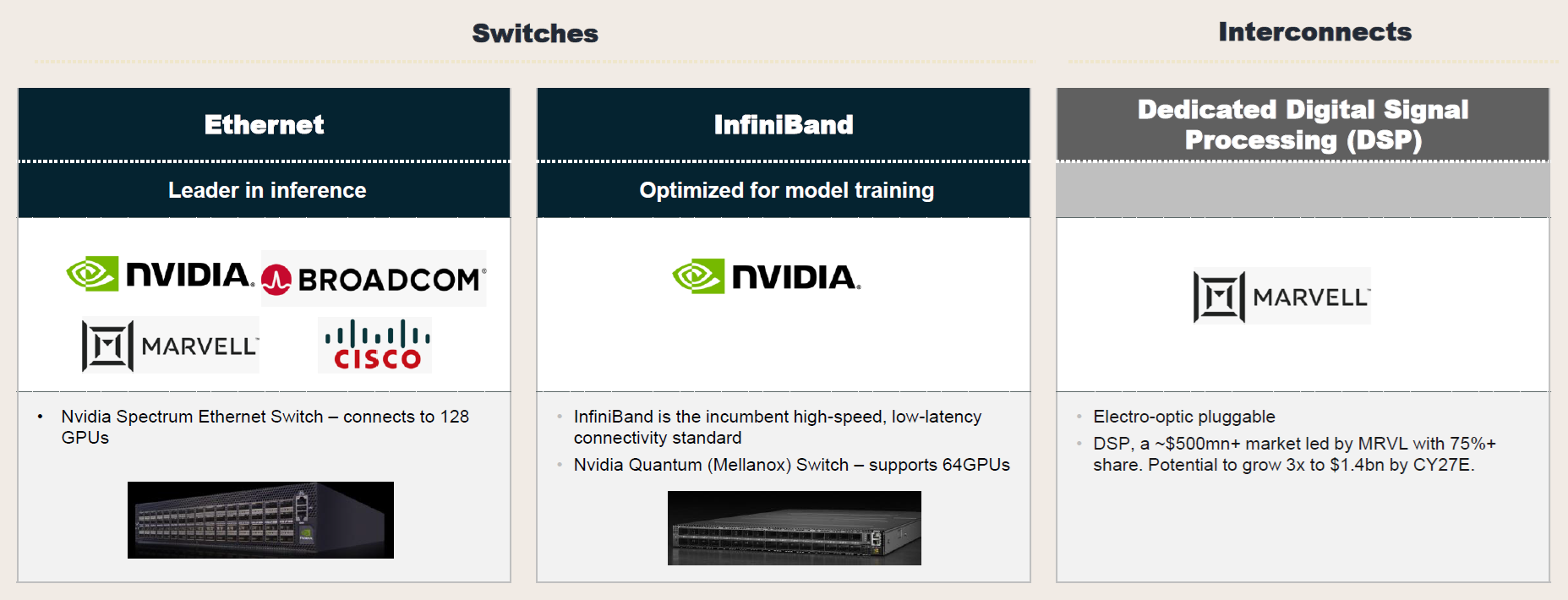

AI 算力更多集中在云端是目前的主流情况。而一套完整的云端 AI 涉及到哪些用于互联的网络呢?

Marvell 在下图做了一个归纳,其认为一共包括四类网络:

(1) Compute fabric(计算架构):连接服务器内的 AI 加速器、GPU、CPU 和其他组件。该架构设计用于在短距离内高速运行,通常依赖于使用 PCIe 或 NVLink 等专有接口的铜线

(2) Backend network(后端网络):使用多层互连的网络交换机和光模块将上述服务器连接成 AI 集群。网络协议包括 InfiniBand 或以太网。

(3) Frontend network(前端网络):将 AI 集群连接到云数据中心,用于存储、交换等。AI 服务器内部的 CPU 负责传输数据,每个 CPU 都有自己的网卡,连接光模块。前端网络使用以太网协议。...