知识块

#MRNBJP

Llama3.1 大模型推理速度对比:Cerebras vs. 基于 Nvidia GPU 的公有云

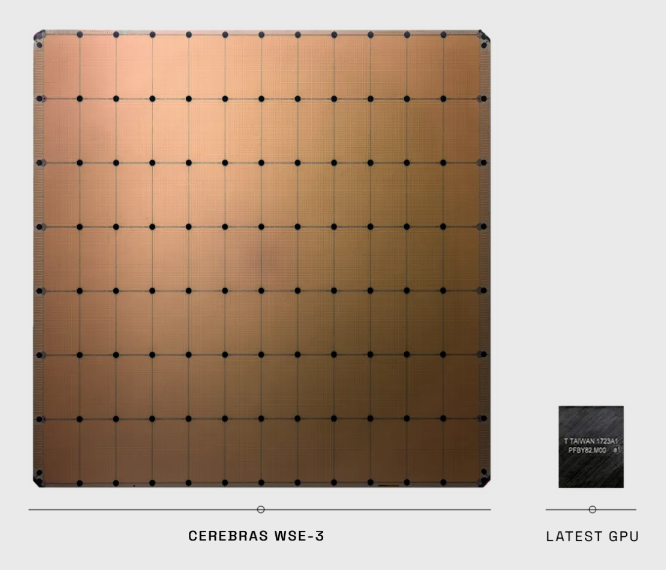

初创公司 Cerebras 披露的数据显示,以 Meta 开源大模型 Llama3.1-70B 为例,其推理解决方案的速度是基于 Nvidia GPU 的公有云服务商速度的 20x 倍以上。

从披露的信息看,Cerebras 制造的推理芯片尺寸比 GPU 要大得多。

附:Llama3.1 有三种规格,8B 适合在消费者级 GPU 上进行高效部署和开发;70B 适合大规模 AI 原生应用;而 405B 则适用于合成数据等。

数据来源

Cerebras

分享链接

http://robin5G.com/MRNBJP

延伸阅读

Gen AI

甲子光年

围绕企业如何部署生成式 AI,在实现途径上有哪些选择?在甲子光年 2025 年的调研显示,Top 3 为:

(1) 调用第三方 API;

(2) 基于开源模型定制开发;

(3) 云服务集成。

其中 (1) 和 (3) 有利于云端,而 (2) 有利于推动本地算力的采购。

GPU

Nvidia

英伟达 Nvidia 不仅是直接销售 GPU 给云服务商或企业,自己也与云服务商合作,通过 DGX Cloud 的形式,销售封装好的软件和模型 AI 能力(服务)。

附图来自 The Information 的整理,Nvidia 承诺在云服务上的金额投入承诺。

大模型

Maxime Labonne

MMLU(大规模多任务语言理解)是一种大模型能力的测试基准,旨在通过在零样本和少样本设置中专门评估模型来衡量预训练期间获得的知识。比较类似评估人类学习能力的方式。该基准涵盖了 STEM、人文科学、社会科学等 57 个学科。

Maxime Labonne 针对主流大模型的 MMLU 测试结果显示,以 Meta Llama 为代表的开源大模型正在缩小与闭环大模型的差距。