知识块

#A8R5NT

AI 训练的加速器数量与算力互联网络的关系

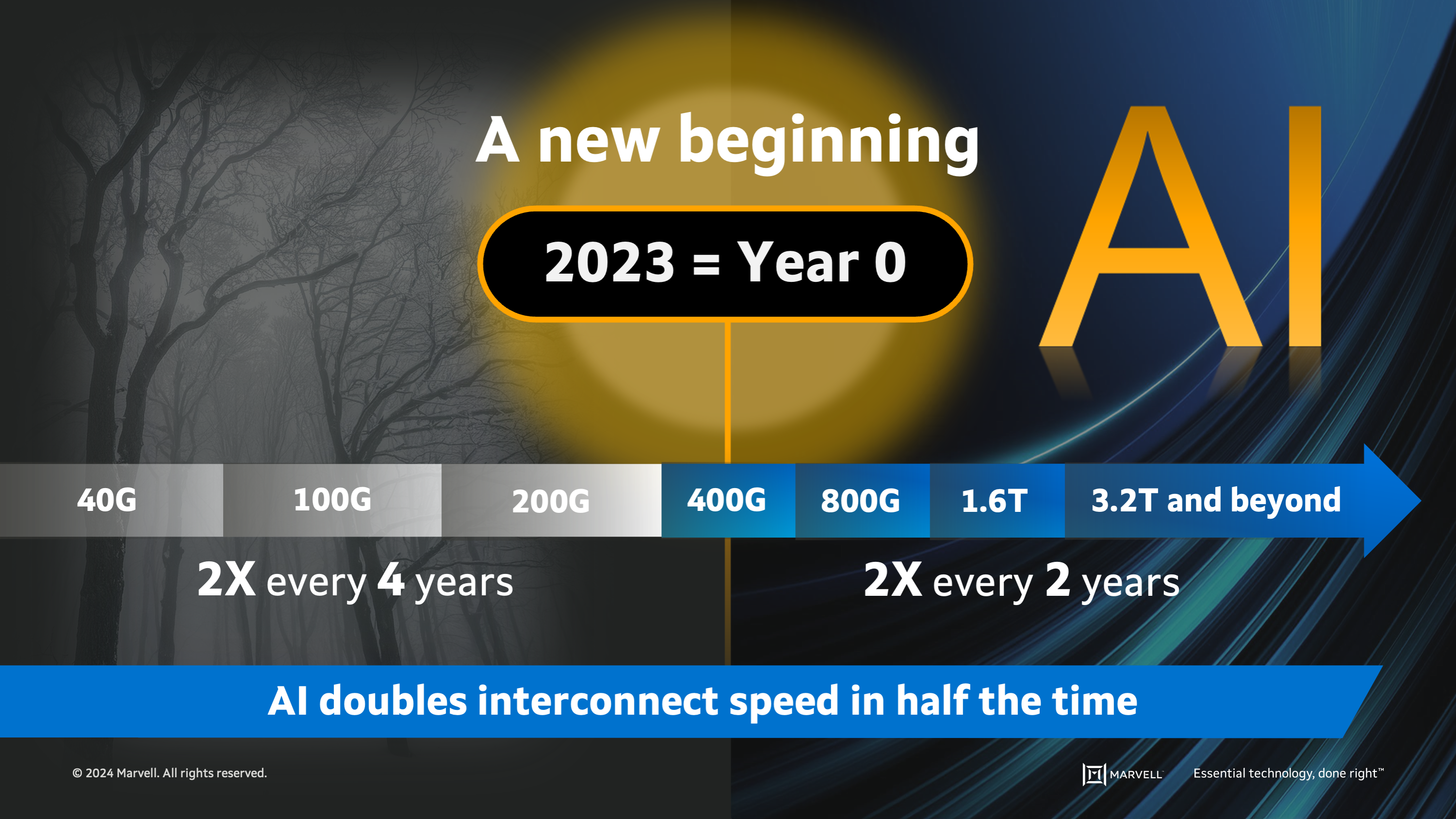

Marvell 认为,如果以 2023 年为分水岭,AI 算力集群的互联网带宽在之前年份大约每隔 4 年会翻倍;而之后年份会提升到每隔 2 年翻倍。

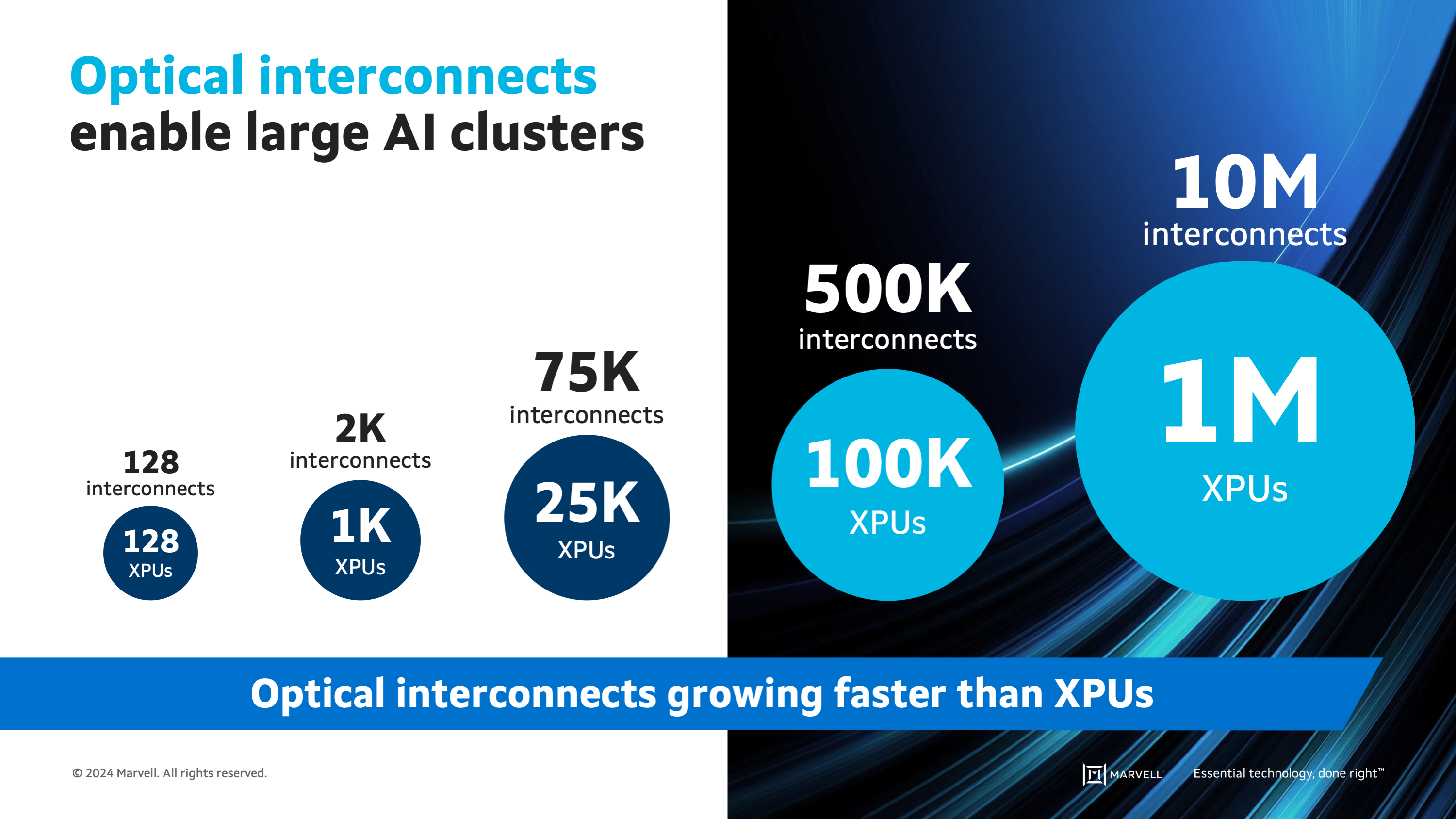

带宽速度是一方面,互联的连接数量也会急剧增加。ChatGPT 在 GPT-3 模型训练时,大约使用了 1,000 个加速器的集群,这需要大约 2,000 个光纤互联连接;而 GPT-4 模型的训练则需要使用 2.5 个加速器的 GPU 集群,这需要大约 7.5 万个光纤互联连接。

光纤互联的连接增长速度将比 XPU/GPU 要块,比例达到 5:1,甚至 10:1。

数据来源

Marvell

分享链接

http://robin5G.com/A8R5NT

延伸阅读

CPU

社群

围绕 CPU 和 GPU 的目标任务差别,有研究认为,有非常多的 AI 计算需求,并不需要 “实时性”。从后台批处理(Batch Processing)、中度延迟(Mid Latency)、低延迟(Low Latency)接近实时(Near Real time)、实时(Real time),计算任务可以分为很多种。

通过 GPU 和 CPU 的组合,可以提升 GPU 任务执行的经济性。

Gen AI

Bloomberg

Bloomberg 研究认为,对比 2022 年的 400 亿美元收入,生成式 AI 的收入空间在 2032 年将达到 1.3 万亿美元,增长 32x 倍。

预计到 2032 年,生成式 AI 的支出占全部科技支出的 12%。

ChatGPT

OpenAI

随着 ChatGPT 用户规模的迅速扩大,其商业化进程也在快速展开。

Open AI 在 2023 年 1 月给出的付费版本定价是每月 42 美元,2 月份其做了调整,价格降为每月 20 美元。

对比免费版,付费版的服务承诺为:① 可用性更高(免费版有时会连不上)、② 更快的问答响应速度、和 ③ 未来的其他新功能。