风险投资机构 a16z 描绘了生成式 AI(AGI)的技术栈层次。最底下两层是计算机硬件(服务器、GPU 等)和云平台(AWS、Google 云、Azure 等);

底下两层可认为提供了算力网络的基础设施服务。深蓝色是模型层,包括闭源的模型(例如:OpenAI 的 GPT-3) 和开源模型。开源模型既包括模型算法本身,也包括托管和运行这些模型的平台。

最上层即应用。应用既可以是 Jasper 这种比较 “薄” 的应用,也包括 Midjourney 这种后台模型也自己做的应用。

从价值创造和风险投资角度,Jasper 类面临的质疑就是护城河问题,有风险投资机构认为其大量能力依赖 OpenAI。而 OpenAI 会把大部分价值拿走等。

但其实即便是比较 “薄” 的上层应用中,Github...

Epoch 研究显示,Google Gemini Ultra 的训练模型达到了 1.91 亿美元,而 OpenAI GPT-4 的训练成本估计为 7800 万美元。

对比,Google 最早的 Transformer 的训练成本仅为 900 美元。

所谓 Scaling laws (尺度定律),最浅显的理解就是物理规模得很大。

ChatGPT 在媒体上的热议已经有几个月了。围绕 ChatGPT 的用户体量会有多大的讨论也是一个有趣的问题。

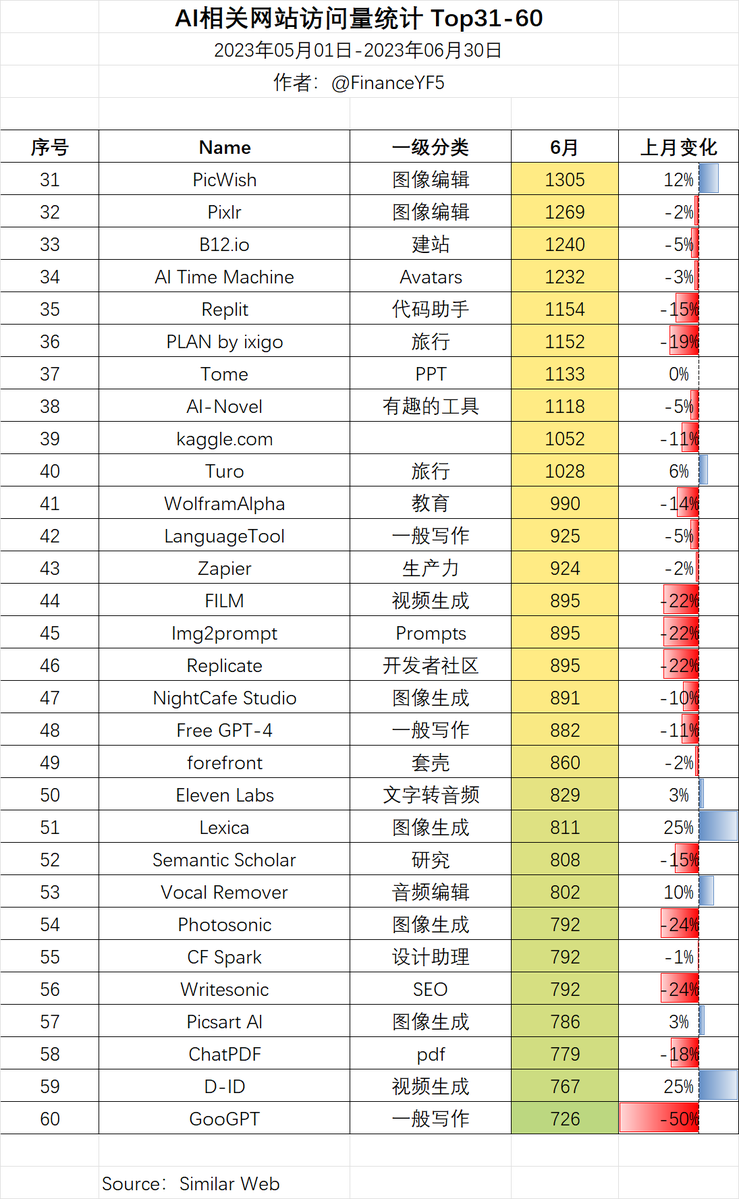

网站数据分析机构 Similarweb 提供了一组数据,可以方便我们了解 ChatGPT 的用户访问规模的进展。

(1) 2023 年 4 月,ChatGPT 的用户访问到了 17.6 亿次;

(2) ChatGPT 的访问量已经超过了 bing.com;当然,需要指出的是,必应搜索引擎虽然搞了很多年,但在搜索引擎的份额一直很小;

(3) ChatGPT 的访问量达到了百度的 60%;

(4) ChatGPT 的访问量只有 Google 的 2%。

最值得关注的是增幅变化,2023 年前四个月的环比增幅,分比为:131.6%,62.5%,55.8%,12.6%。

如果环比增幅下滑过快,ChatGPT...