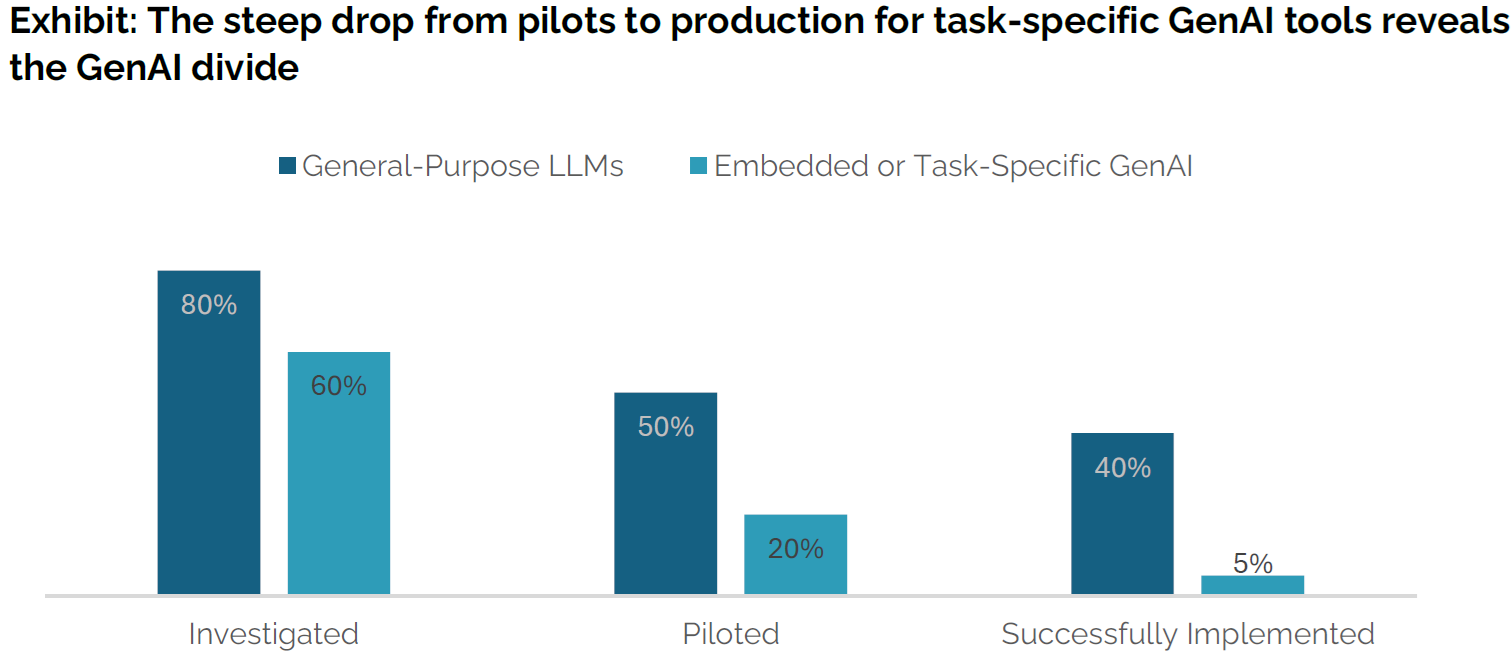

MIT 最近发布的一份报告,关于企业客户在使用大模型工具的成功(部署)的比例。

如果是 ChatGPT 类的通用工具,成功部署的比例为 40%;而如果是面向企业特定的专属任务则成功率只有 5%。

这个现象由来已久,也不仅是 AI 主题。以白领办公常用的即时消息 IM 为例,微信等通用工具的应用体验一定是远好于企业自己开发的专属 IM 的。

就大模型应用而言,OpenAI 的技术实力和研发投入,任何企业客户个体都是无法比拟的。

以训练数据为例,企业把自己手头哪些 PDF 资料给 “搞整齐”,就是一件非常之困难的事情,尤其是考虑到有限的 IT 成本条件下。随便找周遭做类似项目的朋友一问便知。

这个时候问题来了,这些特定任务类作业才是企业的 “生产” 最直接相关的事情 ……

初创公司 Cerebras 披露的数据显示,以 Meta 开源大模型 Llama3.1-70B 为例,其推理解决方案的速度是基于 Nvidia GPU 的公有云服务商速度的 20x 倍以上。

从披露的信息看,Cerebras 制造的推理芯片尺寸比 GPU 要大得多。

附:Llama3.1 有三种规格,8B 适合在消费者级 GPU 上进行高效部署和开发;70B 适合大规模 AI 原生应用;而 405B 则适用于合成数据等。

企业在部署 SaaS 应用时,通常会从第三方 SaaS 商购买若干个账号,并发放给员工。与此同时,员工数也是典型的企业规模划分的维度。

如果把企业在 SaaS 的总支出除以总员工数,可达到每位员工平均 SaaS 的支出。根据 Productiv 的调研,大企业的单位支出是最低的,只有每年 7,500 美元左右,而中小企业的平均的单位支出为 11,000 美元左右,显著高于大型企业。

从这个角度也可以看出大型企业的规模优势。