知识块

#250330AQCZJV

相当大比例的 AI 计算需求并不需要 “实时性”

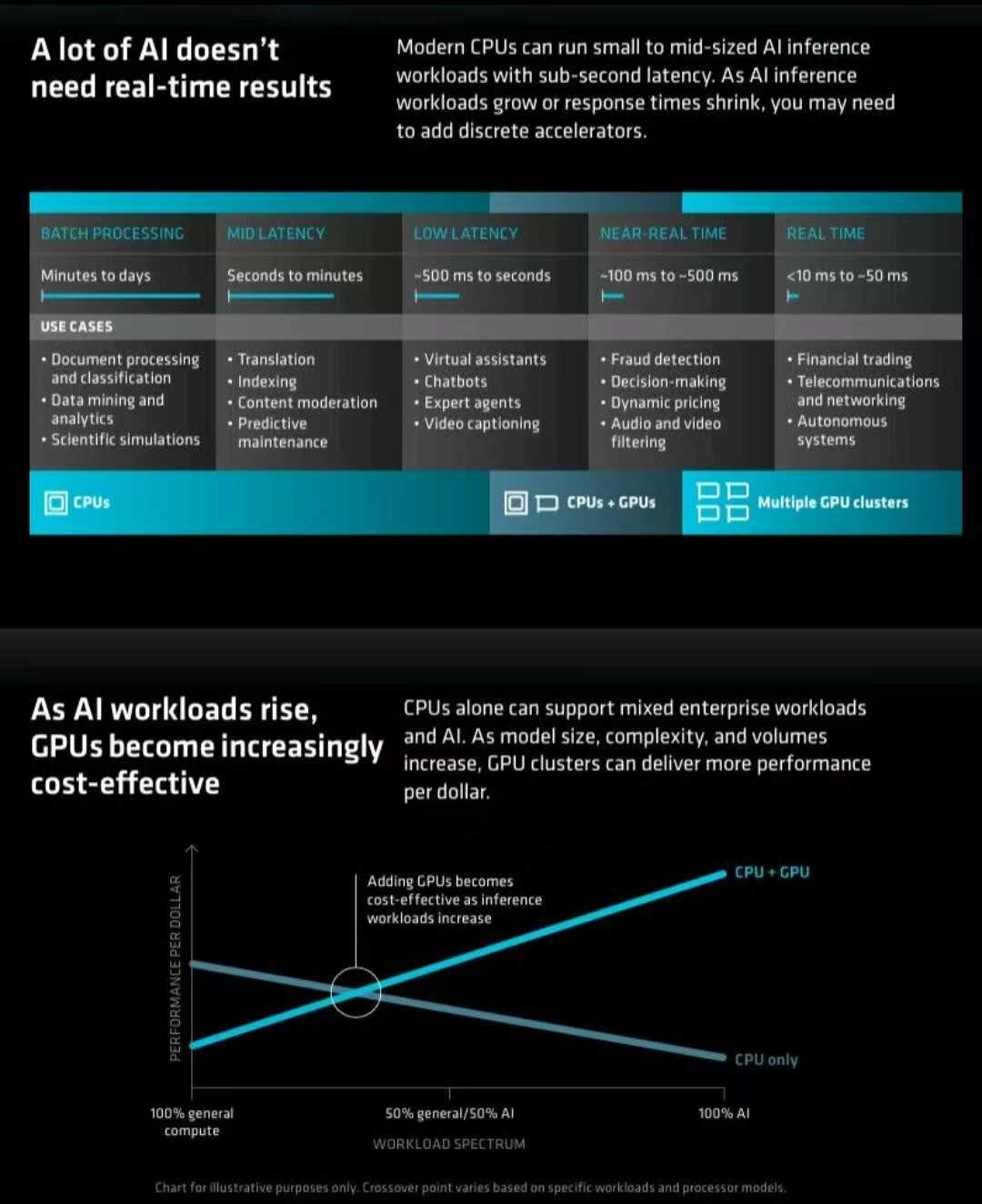

围绕 CPU 和 GPU 的目标任务差别,有研究认为,有非常多的 AI 计算需求,并不需要 “实时性”。从后台批处理(Batch Processing)、中度延迟(Mid Latency)、低延迟(Low Latency)接近实时(Near Real time)、实时(Real time),计算任务可以分为很多种。

通过 GPU 和 CPU 的组合,可以提升 GPU 任务执行的经济性。

数据来源

社群

分享链接

http://robin5G.com/250330AQCZJV

延伸阅读

Apple

创造:用非传统方式做有价值的事 |...

这些东东众说纷纭,还是得看乔布斯重要手下的回忆。

注:作者 Tony Fadell 是 iPod 和 iPhone 的联合设计人之一。

Gen AI

Cerebras

初创公司 Cerebras 披露的数据显示,以 Meta 开源大模型 Llama3.1-70B 为例,其推理解决方案的速度是基于 Nvidia GPU 的公有云服务商速度的 20x 倍以上。

从披露的信息看,Cerebras 制造的推理芯片尺寸比 GPU 要大得多。

附:Llama3.1 有三种规格,8B 适合在消费者级 GPU 上进行高效部署和开发;70B 适合大规模 AI 原生应用;而 405B 则适用于合成数据等。

AI

eMarketer

Morning Consult 在 2023 年 2 月的一项调研,针对美国消费者希望的兴趣,针对基于 AI 的产品和服务意向上。

Top 3 应用是:(1) 基于 AI 的在线搜索;(2) AI 生成食谱;(3) 基于 AI 的道路救援。

从调研选项看,这个问卷贴近消费者日常生活的方方面面。