生成式 AI 发展大趋势下,各种大语言模型(LLM)如雨后春笋般出现。除了 OpenAI 的 GPT 和 Google 的大模外,还有各种开源模型。在 Hugging Face 上宣称有 30 万种模型可供选择。

对于应用开发商而言,一种主流的手段就是像使用云计算算力一样,通过互联网 API 去调用大模型服务商的模型能力,然后按照使用次数去付费。

由于不同大模型的计算质量以及品牌有差别,此类 AI 算力服务的价格也差别很大。例如,GPT-4 会比 GPT-3.5-Turbo 贵 30x 倍;GPT-4 比其他某些模型服务商贵甚至 100x 倍。

这就给应用商带来一个问题,对于 “普通的计算请求” 是否也需要用 “很贵的 GPT-4” ?可否用便宜一些的其他模型服务来代替 GPT-4。

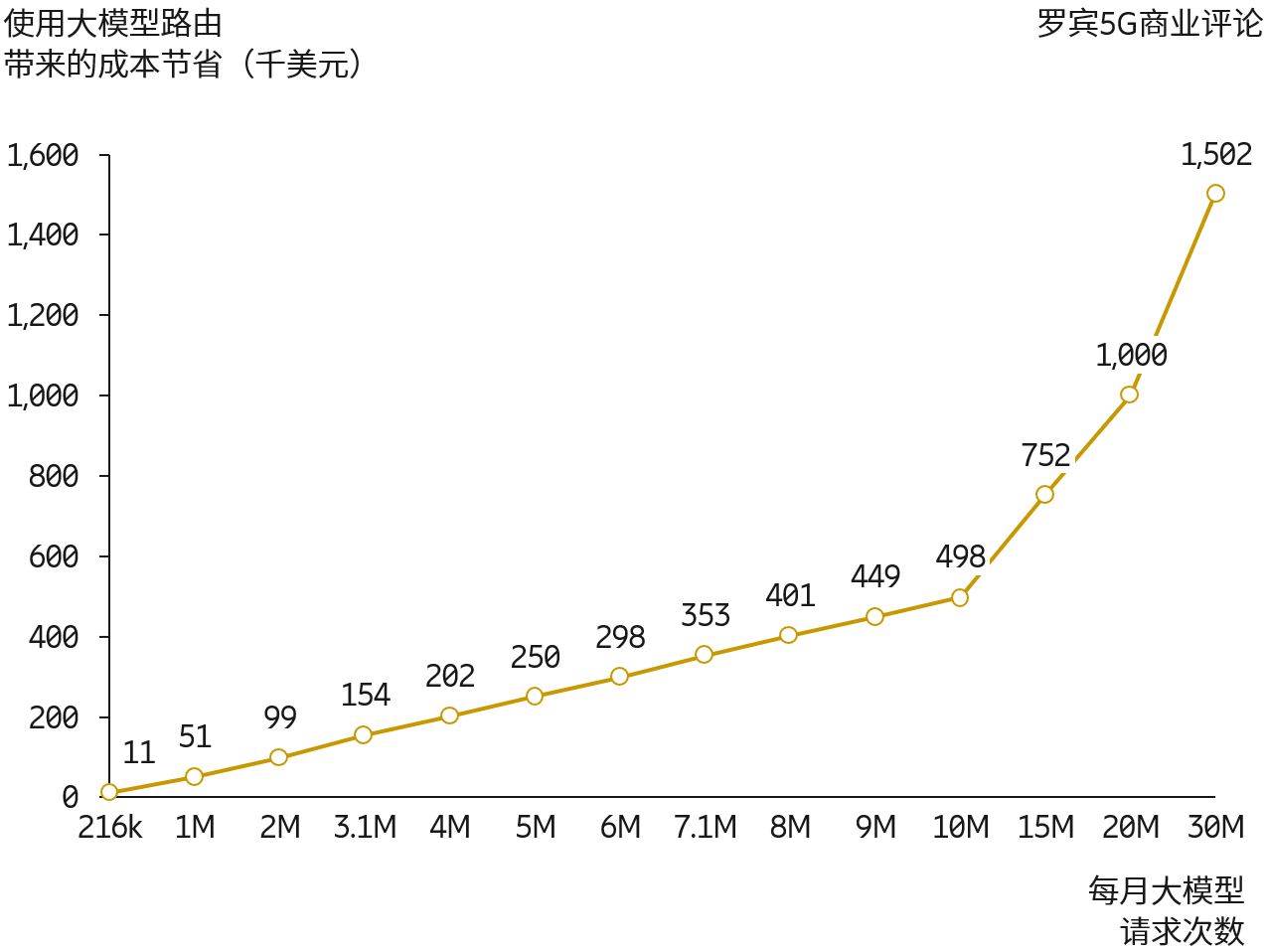

创业公司 Martian 就在走类似事情,其提供了 “Model Router 模型路由” 服务,帮助应用上来做自动路由选择,力求把普通的计算请求应用于便宜一些的大模型服务上去。

附图数据来自 Martian 的模拟,其认为通过模型路由,节省最高 98% 的大模型能力调用成本。

初创公司 Cerebras 披露的数据显示,以 Meta 开源大模型 Llama3.1-70B 为例,其推理解决方案的速度是基于 Nvidia GPU 的公有云服务商速度的 20x 倍以上。

从披露的信息看,Cerebras 制造的推理芯片尺寸比 GPU 要大得多。

附:Llama3.1 有三种规格,8B 适合在消费者级 GPU 上进行高效部署和开发;70B 适合大规模 AI 原生应用;而 405B 则适用于合成数据等。

附件 PPT 来自红杉资本(Sequoia Capital)美国。

图 1:生成式 AI 目前达到了 30 亿美元的收入,大约花费了一年多时间。而 SaaS 达到类似水平花费了十年。

图 2:CB Insights 统计的已披露大模型相关投资并购案例的数据,大约 200 多亿美元的资金中,有 169 亿美元投向了基础设施,尤其是英伟达的 GPU。

根据红杉资本的研究,其认为过一年一共有 500 亿美元花费在了生成式 AI 上面(包含数据中心配套的机房、供电等)。

500 亿美元 vs. 30 亿美元,是过热了,还是伟大征程的开始?

The Economist 报道,Apple 和 Google 的应用商店有超过 40 万款健康保健类的 App,每天新增 250 款。

用户角度,每天会下载 500 万次健康类的 App,但其中大约 95% 会在 24 小时内被删除。

论健康类赛道的火热与存活难度……